vue 实现活体检测

活体检测的基本概念

活体检测用于区分真实用户与伪造攻击(如照片、视频或面具),通常结合人脸识别技术使用。在Vue中实现活体检测,需依赖浏览器API或第三方SDK(如百度AI、腾讯云等)。

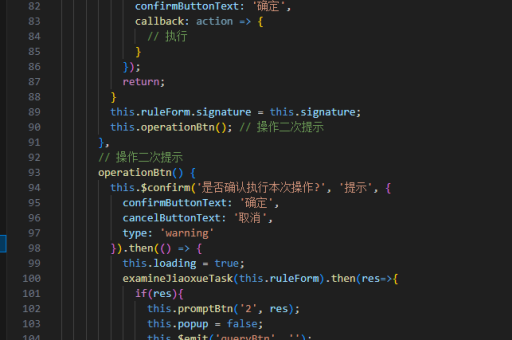

方法一:基于WebRTC的摄像头捕获

通过浏览器摄像头获取实时视频流,结合动作指令(如眨眼、摇头)完成活体验证。

-

请求摄像头权限

使用navigator.mediaDevices.getUserMedia获取视频流并绑定到<video>元素:async function startCamera() { const stream = await navigator.mediaDevices.getUserMedia({ video: true }); const videoElement = document.getElementById('video'); videoElement.srcObject = stream; } -

动作指令检测

通过canvas捕获视频帧,使用库(如face-api.js)检测面部动作:

const canvas = document.getElementById('canvas'); const context = canvas.getContext('2d'); context.drawImage(videoElement, 0, 0, canvas.width, canvas.height); // 使用face-api.js检测眨眼或头部姿态

方法二:集成第三方SDK

以百度AI活体检测为例:

-

安装SDK

引入百度AI的JavaScript SDK:npm install baidu-aip-sdk -

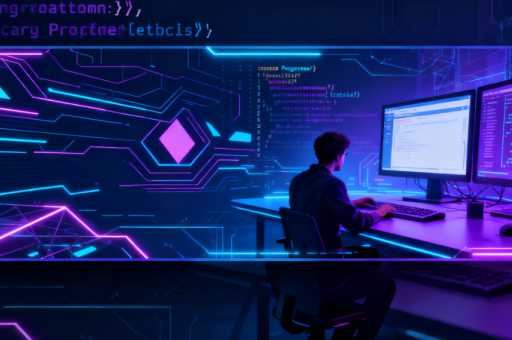

调用活体检测API

在Vue组件中调用SDK:

import AipFaceClient from 'baidu-aip-sdk'; const client = new AipFaceClient(APP_ID, API_KEY, SECRET_KEY); async function livenessCheck(imageBase64) { const result = await client.livenessVerify(imageBase64); return result.result > 0.8; // 根据置信度阈值判断 }

方法三:结合深度学习模型

使用TensorFlow.js或预训练模型(如BlazeFace)在浏览器端运行活体检测:

-

加载模型

import * as blazeface from '@tensorflow-models/blazeface'; const model = await blazeface.load(); -

实时检测与验证

const predictions = await model.estimateFaces(videoElement); if (predictions.length > 0) { // 检查面部特征点变化(如眼球运动) }

注意事项

- 用户隐私:需明确告知用户摄像头用途,遵守GDPR等法规。

- 兼容性:WebRTC在部分浏览器(如iOS Safari)可能需要额外配置。

- 性能优化:减少实时检测的帧率以降低CPU负载。

通过上述方法,Vue应用可实现基础的活体检测功能,复杂场景建议结合后端服务增强安全性。